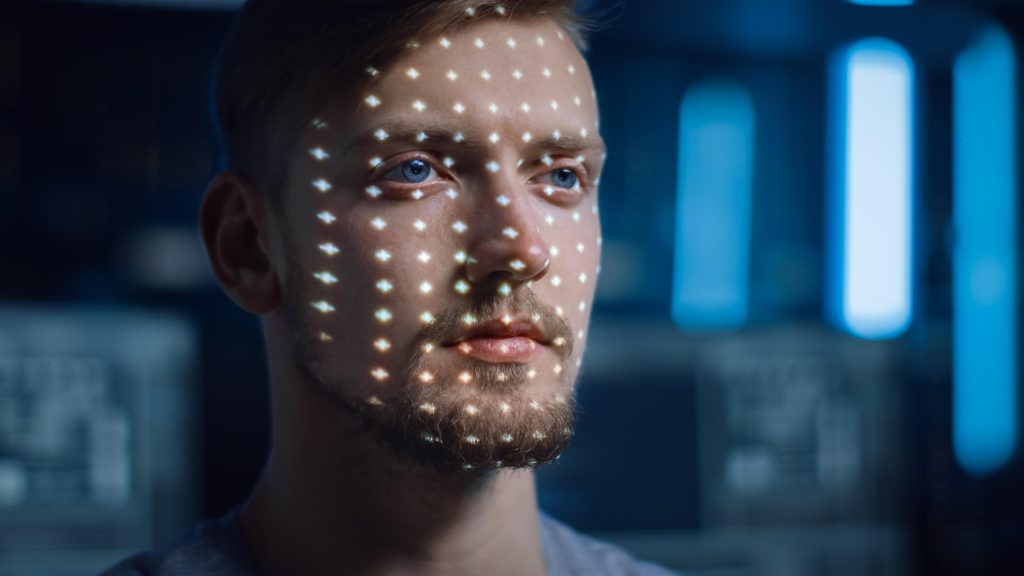

Da mesma forma que as eleições de 2008 foram marcadas pela influência massiva (e até então, inédita) das redes sociais, o pleito de 2024 promete ser um marco para os novos padrões no uso da tecnologia na política. Nesse caso, até mais grave: a bola da vez é a Inteligência Artificial Generativa e a criação de conteúdo deepfake.

Recentemente, o Tribunal Superior Eleitoral (TSE) aprovou uma série de resoluções que são um primeiro passo na regulamentação do uso de IA em campanhas eleitorais. As novas regras incluem a proibição total de deepfakes, restrições ao uso de chatbots e avatares nas campanhas, e a exigência de identificação clara de conteúdo multimídia sintético.

A ministra Cármen Lúcia ressaltou que a tecnologia deve ser uma aliada da democracia, e não uma ferramenta para “desservi-la”. Um ponto interessante é a criação de um repositório para armazenar e expor conteúdos considerados inverídicos ou descontextualizados, uma espécie de “museu das fake news”, talvez?

Há mais de 20 anos no mercado, a empresa pernambucana Neurotech faz uso massivo de Inteligência Artificial na análise dos dados dos seus clientes, extraindo melhores insights a partir da tecnologia. Mas como explica o CEO da companhia, Domingos Monteiro, a ferramenta também tem seu lado negativo. “A preocupação do TSE é justificável, os avanços das LLMs (Large Language Models) nos últimos 12 meses nos trouxe a um mundo completamente novo. E como é o caso para toda tecnologia revolucionária, sempre temos grandes oportunidades a serem exploradas mas também novas ameaças – algumas não tão novas assim”, avalia.

Além disso, como dissemos antes, essas novas normas são um começo – e um começo é um começo, tem muito para avançar ainda. Por exemplo, a legislação eleitoral agora proíbe completamente o uso de deepfakes e exige que material que fez uso de IA seja sinalizado. O descumprimento pode levar a cassação de registro e mandato, assim como as redes sociais devem trabalhar para impedir a circulação do material falso, sob o risco de também serem penalizadas. Porém, isso vale para campanhas oficiais – e a lei ainda é vaga sobre como proceder quando o deepfake vem de uma fonte “não-oficial”, como por exemplo um usuário comum que é apoiador do candidato.

“As novas normas têm um efeito importante para trazer visibilidade para as possíveis novas formas de ameaças que surgem com a aplicação destas novas tecnologias em uma disputa eleitoral. Acho que este efeito de informar e de ‘educar’ o eleitor para esta possibilidade não deve ser minimizado”, acredita Domingos, que avalia ainda que, a princípio, as novas normas terão pouco efeito prático para barrar ou inibir a desinformação. “Quem tiver interesse em desinformar irá usar todo o arsenal que estiver à sua disposição, incluindo as novas tecnologias, como é o exemplo das deepfakes”, completa.

Enquanto isso, pelo mundo afora, vemos uma variedade de abordagens. Em alguns países, como nos Estados Unidos, a regulação da IA em eleições ainda é um terreno nebuloso. Existe um consenso crescente sobre a importância de leis que previnam a disseminação de desinformação criada por IA, como os deepfakes, que já causaram problemas em eleições anteriores, incluindo gravações falsificadas e ligações robóticas que imitam figuras públicas.

Mas apesar do reconhecimento dessa necessidade, o Congresso norte-americano parece improvável de aprovar uma legislação abrangente sobre IA em breve. Esforços, como os do líder da maioria no Senado, Chuck Schumer, para dar prioridade à regulamentação da IA, foram paralisados devido ao impasse habitual no Congresso, com debates intensos sobre liberdade de expressão versus a necessidade de controle. Essa inação é preocupante, considerando as eleições iminentes e o rápido desenvolvimento da IA.

Foram apresentadas várias propostas, incluindo a proibição de deepfakes enganosos em eleições e regulamentações para modelos de IA de alto risco. No entanto, a abundância de ideias não se traduziu em ação concreta.

O atraso nos EUA contrasta com ações em outras regiões, como a União Europeia, que está avançando com sua Lei de IA. Existe uma tendência a adotar regulamentações mais rígidas, seguindo a linha do Regulamento Geral de Proteção de Dados (GDPR), que coloca a privacidade e a transparência em primeiro plano.

Recentemente, políticos europeus em dois comitês-chave aprovaram novas regras para regular a IA, um texto que pode se tornar um referencial global. A legislação exige que modelos de base e sistemas de IA de uso geral cumpram obrigações de transparência antes de serem colocados no mercado. Isso inclui a elaboração de documentação técnica, conformidade com a lei de direitos autorais da UE e a divulgação de resumos detalhados sobre o conteúdo usado para treinamento.

As empresas de tecnologia que fazem negócios na UE serão obrigadas a divulgar os dados usados para treinar sistemas de IA e realizar testes de produtos, especialmente aqueles utilizados em aplicações de alto risco, como veículos autônomos e cuidados de saúde. A legislação proíbe a raspagem indiscriminada de imagens da internet ou de filmagens de segurança para criar bancos de dados de reconhecimento facial, mas inclui exceções para o uso de reconhecimento facial “em tempo real” por autoridades policiais para investigar terrorismo e crimes graves.

Grandes empresas de tecnologia, acostumadas a agir principalmente quando pressionadas, dessa vez se anteciparam, criando uma aliança, para trabalhar de forma colaborativa para barrar o uso ilegal de IA e deepfake em eleições. Esse grupo inclui Amazon, Google, Microsoft, Meta, TikTok, OpenAI, Adobe e outras.

O “Tech Accord to Combat Deceptive Use of AI in 2024 Elections” é um compromisso conjunto dessas empresas para combater conteúdos prejudiciais gerados por IA que visam enganar eleitores. Os signatários da aliança se comprometem a trabalhar colaborativamente no desenvolvimento de ferramentas para detectar e abordar a distribuição online desses conteúdos. Entre as ações, estão campanhas educacionais e o fornecimento de transparência sobre o problema. Isso inclui o acompanhamento da origem de conteúdo eleitoral enganoso e a conscientização pública sobre o problema.

“A entrada das Big Techs no combate ao uso das novas tecnologias para práticas nem tão novas assim, servem de reforço importante no combate à desinformação”, afirma o CEO da Neurotech. “A parceria do TSE com as Big Techs e o investimento em campanhas de informação serão grandes aliados para enfrentar esta nova realidade que vivemos. Em resumo, não adianta combater a tecnologia ou tentar evitar o seu uso, mas sim usar a mesma tecnologia como aliada para combater a desinformação”, completa o executivo.

Uma reflexão que não podemos deixar de fazer é: até que ponto a regulação pode realmente acompanhar o ritmo frenético da evolução tecnológica? Enquanto legislamos sobre deepfakes e chatbots, novas formas de IA estão emergindo, trazendo novos desafios. Como dizia o sábio: “A única constante é a mudança”, especialmente no mundo da tecnologia.

O Brasil está tomando passos importantes para assegurar a integridade das suas eleições na era digital, enquanto outros países observam e aprendem. Cada país com suas peculiaridades, mas todos em busca de um objetivo comum: garantir que a voz do povo seja ouvida e respeitada, sem interferências indesejadas de robôs controlados por atores mal-intencionados. E quem sabe, com um pouco de sorte e muita vigilância, a democracia saia mais fortalecida dessa era digital. Vamos aguardar os próximos capítulos dessa novela eleitoral high-tech!

Renato Mota é jornalista, e cobre o setor de Tecnologia há mais de 15 anos. Já trabalhou nas redações do Jornal do Commercio, CanalTech, Olhar Digital e The BRIEF

Comments are closed, but trackbacks and pingbacks are open.